Runway 推出了文字生成短影片的AI 模型Gen-2,只需输入文字指令提示即可创造出影片。但也存在影片长度偏短、画面较为不稳定等缺陷。

Runway 致力于构建多模态 AI 系统以启用新型创意工具。Runway 也是协助开发Stable Diffusion 的参与者之一,主要提供web 环境的AI 影片剪辑工具,包括去背、侦测影片人物动作的功能。近日,Runway 推出了文字生成短影片的AI 模型Gen-2,为二月推出之模型Gen-1 的改进版本。

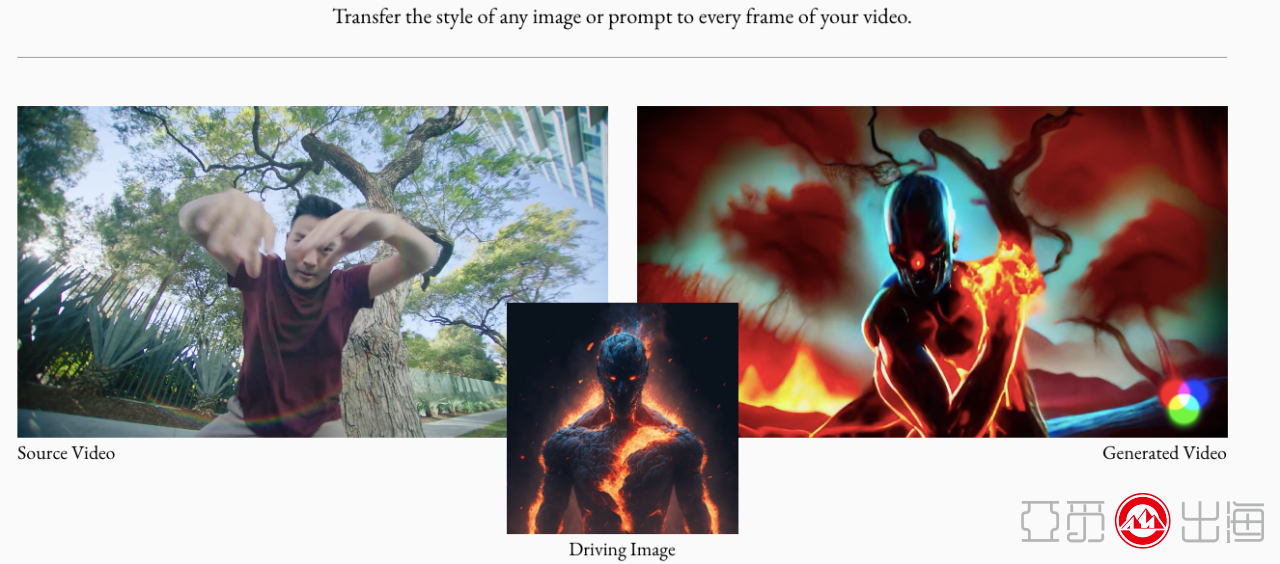

Runway 的Gen-1 系统让使用者输入一段影片后,能使用文字指令来加以剪辑,例如将影片中的车辆换颜色等;也可以藉由输入一张图像,让AI 将图像风格后套在既有影片上。

新模型Gen-2 则不需要先输入一支影片或图片作为风格参考,只需输入文字指令提示即可创造出影片。当然使用者也能再上传一张图片外加文字指令,或只凭一张图像来生成影片。

不过,目前AI生成影片仍可看出一些缺陷,例如影片长度偏短、画面较为不稳定,有人物出现时仍和真实影片有落差。

目前Meta 和Google 已在去年推出自家文字生成影片AI 模型Make-A-Video和Imagen Video,随着生成影片AI 的崛起,打开了新的创作方式。在电商领域,可以利用这一工具进行素材生成、短视频合成等方面,企业宣传短片、TikTok短视频,产品广告片都可以利用这一AI工具,有效提升视频质感和降低人工成本。

Gen-2 的程式化应用:将任何图像或提示的风格转移到视频的每一帧

【原创申明】为了更好保护支持原创内容和对忠实读者负责,本网站跨境阿米SHOW(网站地址:www.amishow.com)及公众号跨境阿米SHOW(微信号:amishow321)刊载的包括文字、图片、音频、视频等所有内容,除签署正式付费转载协议伙伴外,禁止任何形式的复制、转载、修改或者以其他方式使用本网站或本公众号的内容。本网站或本公众号部分引用资料只代表原作者意见,不代表本网站www.amishow.com或者本公众号『跨境阿米SHOW』任何立场,如发现本站文字存在版权疑问,请联系我们「微信号:amishow01」「邮箱copyright@amishow.com」处理。

发表评论

请先登录后参与评论

{{ item.user_info.display_name }}